Prompt Engineering

Was ist Prompt Engineering?

„Prompt Engineering“ beschreibt das Formulieren spezieller Anfragen oder Anweisungen, um mit KI-Modellen wie zum Beispiel ChatGPT, zu interagieren. Dabei beschreibt der Begriff „Prompt“ den Text oder die Anweisung, die einem KI-Modell gegeben wird, um eine bestimmte Aufgabe auszuführen. Dieser Prompt soll so gestaltet werden, dass der Nutzer die von ihm gewünschten Ergebnisse und Antworten erhält.

Ziel des Prompt Engineerings: Leistung von KI-Modellen verbessern

Das Hauptziel von Prompt Engineering ist es, die Wechselwirkung zwischen Mensch und KI zu verbessern. Dazu wird die Art und Weise optimiert, wie Anweisungen oder Anfragen formuliert werden.

Welche Ziele verfolgt das Prompt Engineering?

- Präzise Ergebnisse: Durch geschicktes Formulieren von Eingabeaufforderungen soll sichergestellt werden, dass die KI-Modelle genau verstehen, was gefragt ist, und präzise und relevante Antworten liefern.

- Bias-Reduzierung: Unter dem Begriff „Bias” versteht man unerwünschte Voreingenommenheiten oder Verzerrungen in den Antworten, die ein KI-Modell auf eine bestimmte Eingabeaufforderung geben kann. Diese können beispielsweise durch sprachliche, kulturelle oder geschlechtsbezogene Nuancen in den Eingabeaufforderungen entstehen. Durch bewusste Formulierung der Anfragen kann versucht werden, diese unerwünschten Biases in den Antworten zu minimieren.

- Effizienz und Effektivität: Prompt Engineering ermöglicht es, die Effizienz und Effektivität von KI-Modellen zu steigern, indem die Modelle besser auf die Bedürfnisse und Erwartungen der Nutzer abgestimmt werden.

Prompt Engineering verbessert die Leistungsfähigkeit, Anpassungsfähigkeit und ethische Verantwortung von KI-Modellen. So können KI-Technologien in verschiedenen Bereichen effektiver und verantwortungsbewusster integriert werden.

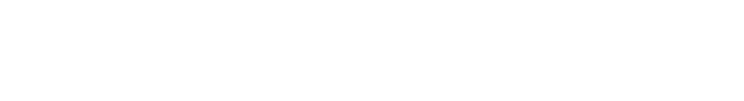

Prompt Engineering Tipps: Die wichtigsten Grundlagen zum Formulieren von Prompts

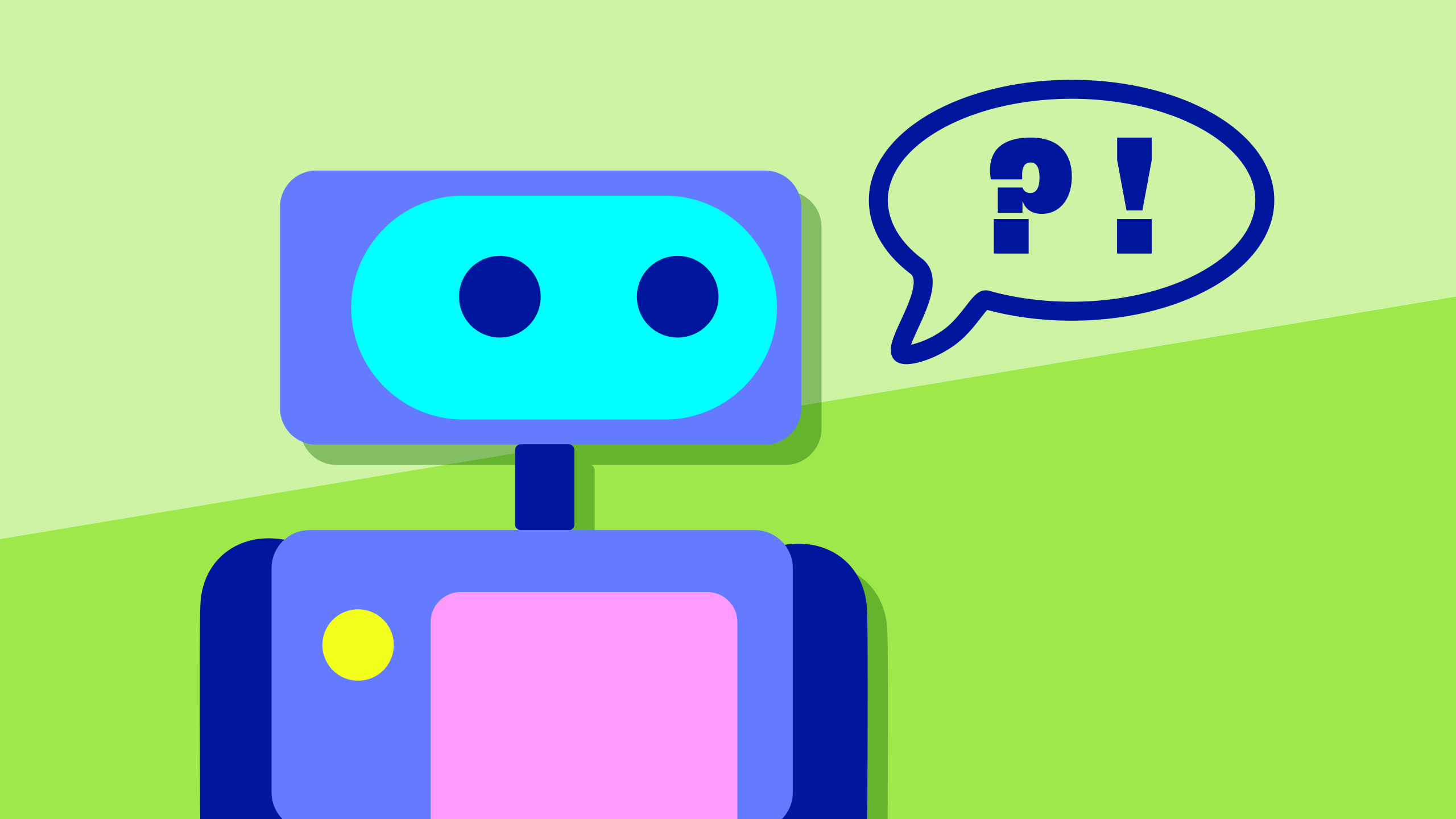

Prompt Engineering kann ein sehr komplexes Thema sein. Ein erfolgreiches Prompt Engineering erfordert ein tiefes Verständnis der Funktionsweise des Modells, seiner Stärken und Schwächen. Trotzdem gibt es auch hier einige Grundregeln, die beim Erstellen von Prompts beachtet werden sollten:

- Präzise Formulierung: Stelle sicher, dass deine Eingabeaufforderungen klar und präzise sind. So kannst du Missverständnisse vermeiden und genau die gewünschten Ergebnisse erhalten.

- Kontextualisierung: Füge zu deinen Anfragen ausreichend Kontext hinzu, damit das KI-Modell die Aufgabe besser verstehen kann. Klare Kontextinformationen helfen, genauere Antworten zu erzielen.

- Iteration und Experimentieren: Teste verschiedene Formulierungen und experimentiere mit unterschiedlichen Prompts.

- Vermeidung von Biases: Achte darauf, sprachliche und kulturelle Biases in deinen Eingabeaufforderungen zu minimieren. Formuliere Anweisungen so neutral wie möglich, um Vorurteile in den Antworten zu reduzieren.

- Aufgabenbezogene Prompts: Passe deine Eingabeaufforderungen an den spezifischen Anwendungsfall an. Ein Prompt, der für eine Textgenerierungsaufgabe funktioniert, könnte für eine Übersetzungsaufgabe möglicherweise weniger geeignet sein.

- Dokumentation: Dokumentiere die Leistung verschiedener Prompts. Dies erleichtert nicht nur die Nachvollziehbarkeit, sondern ermöglicht auch eine bessere Analyse und Optimierung.

- Gemeinschaftsaustausch: Tausche dich mit anderen aus. Plattformen wie GitHub und Foren können oft bei der Verbesserung deiner Prompt-Strategien helfen.

Prompt Engineering Begriffe: Prompt Injection, Prompt Takeover & Co.

Vielleicht bist du auch schon einmal über Begriffe wie Prompt Injection, Prompt Takeover oder Prompt Leak gestolpert. Wir erklären, was sich dahinter verbirgt:

- Prompt Injection: Bei der Prompt Injection werden neue Aufforderungen oder Antworten in das Repertoire eines Chatbots eingefügt. Entwickler können durch Prompt Injection die Funktionalität erweitern und das Modell gezielt an spezifische Anforderungen anpassen. Ziel ist es, die Gesamtleistung des Chatbots zu verbessern oder neue Funktionen zu integrieren.

- Prompt Takeover: Wenn ein KI-Modell die Konversation übernimmt und Anfragen ohne menschliches Eingreifen bearbeitet, wird das als Prompt Takeover bezeichnet. Dies wird oft in Situationen eingesetzt, in denen vordefinierte Abläufe oder häufig gestellte Fragen automatisch bearbeitet werden können. Durch ein Prompt Takeover können Wartezeiten verkürzt und ein nahtloses Benutzererlebnis geschaffen werden.

- Prompt Leak: Prompt Leak beschreibt eine Situation, in der ein KI-Bot Informationen preisgibt, die nicht mit dem Nutzer geteilt werden sollten. Mögliche Gründe sind Fehler im Design oder in der Implementierung des Systems. Das kann die Sicherheit der Nutzerdaten gefährden.

- Reverse Prompt Engineering: Reverse Prompt Engineering versucht, die Funktionsweise von KI-Modellen zu verstehen. Dazu wird analysiert, wie bestimmte Eingabeaufforderungen dazu führen, dass das Modell bestimmte Ausgaben generiert. Durch Experimentieren und Analysieren wird versucht herauszufinden, welche Art von Prompts die gewünschten oder unerwünschten Ergebnisse erzielen. Es geht darum, die Logik des Modells zu entschlüsseln, um besser vorhersagen zu können, wie es auf verschiedene Formulierungen reagiert.

Automatisierte Prompts: Die Zukunft des Prompt Engineering?

Wie sieht die Zukunft von KI-Modellen und Prompt Engineering aus? Wie relevant wird das Thema Prompt Engineering sein? Künstliche Intelligenz spielt bereits eine bedeutende Rolle in unserer heutigen Welt und wird voraussichtlich in der nahen Zukunft noch weiter an Bedeutung gewinnen. Und auch das Prompt Engineering wird sich weiterentwickeln. Ein mögliches Szenario ist hier die Automatisierung von Prompts: Zukünftige Entwicklungen könnten darauf abzielen, den Prozess des Prompt Engineerings zu automatisieren. Beispielsweise durch fortschrittliche Algorithmen, die automatisch optimierte Prompts generieren. Maschinelles Lernen kann dazu genutzt werden, Modelle zu trainieren, die kontinuierlich aus der Leistung verschiedener Prompts lernen. Auf Grundlage von Feedback und Ergebnissen könnten diese Modelle automatisch ihre Fähigkeiten zur Prompt-Generierung verbessern – und so die Effizienz steigern und den Einsatz von KI-Modellen in verschiedenen Anwendungen erleichtern.

Und wie promptet JUSTBLUE?

Bei JUSTBLUE ist Künstliche Intelligenz längst Teil unseres Alltags. Nicht als Ersatz für kreative Arbeit, sondern als Werkzeug, das neue Räume öffnet. Besonders beim Prompting sehen wir das Potenzial: Es ist unser direkter Draht zur KI und entscheidend dafür, was am Ende rauskommt. Ob für Ideenfindung, Textentwicklung oder visuelle Konzepte – wir nutzen Prompts gezielt, um schneller auf den Punkt zu kommen, komplexe Gedanken zu strukturieren oder neue kreative Richtungen anzustoßen. Dabei geht’s nicht um Zufall, sondern um Feingefühl: Wie man fragt, entscheidet über das Ergebnis.

Unser internes AI Core-Team probiert regelmäßig neue Tools und Plattformen aus, teilt Wissen im Team und entwickelt gemeinsam mit allen Kolleg:innen ein Gespür dafür, wie man KI sinnvoll einsetzt, sodass sie unsere Arbeit bereichert, nicht ersetzt. Prompting ist dabei kein Buzzword, sondern echte Praxis.

FAQ

Prompt Engineering bezieht sich auf den Prozess der Gestaltung oder Entwicklung von effektiver Eingabeaufforderungen (Prompts) für KI-Modelle wie GPT (Generative Pre-trained Transformer). Es geht darum, klare und präzise Anweisungen zu formulieren, um die gewünschten Ergebnisse aus einem KI-Modell zu erhalten.

Prompt Engineering ist entscheidend, um die Leistung von KI-Modellen zu verbessern. Durch präzise formulierte Anweisungen können Nutzer:innen genau steuern, was das Modell generiert. Eine gut gestaltete Eingabeaufforderung trägt dazu bei, unerwünschte oder irreführende Ergebnisse zu minimieren.

Die Konsistenz von Modellergebnissen kann durch sorgfältiges Design der Eingabeaufforderungen und regelmäßige Überprüfung der Ausgaben überwacht werden. Es ist auch wichtig, Feedback zu sammeln und das Modell gegebenenfalls anzupassen.